写在前面

这篇文章是在读@猫梨写的Milestone & Revolution :WWDC20的时候有感而发所写。猫梨的文章介绍了WWDC20上所发布的更新及它们背后的意义,我觉得写得很不错。如果大家对WWDC20的内容感兴趣的话可以前去阅读。而他文中介绍过的事物和所提到的点我这里就不多赘述了,这里只简单列一下我对WWDC20的五个零散的猜想。

(这篇文章原本是发在原文的评论中的。写完之后才发现写了好多,所以就直接在这里重新发出来水一篇了。毕竟有很多也是我一直想写的东西,做个记录也不错。)

App Clips与5G

App Clips并非是一个复杂的需求,为何会在这个时间节点才推出呢?这个举动就很值得玩味了。如果秋季发布带5G的iPhone12的话(几乎板上钉钉),这一点到时肯定会被再拿出来大书特书的。可以预见在5G场景下,App Clips打开的耗时几乎会和如今扫码打开网页的时间持平。这样App Clips将是苹果给5G带来的一大杀手级特性。

App的交互带给用户的观念会从“要事先连Wi-Fi下载/准备好的某个臃肿的东西”变成“某个和网页一样一扫就能看的页面”,这点无疑会为App Store掀起一阵新的浪潮。

有一份2017年的调查指出,虽然App Store上已有数百万个app,但中国iOS用户手机上平均安装的app数量却仅为100个左右,而中国iOS用户平均每月常用的app数量只有约40个,这使得app市场会趋向于大使用群体、排行榜导向的“精英主义”。但在App Clips+5G下,app会出现“能够在xx场景中一扫/一碰就能用”这样的需求。可以预见,与当时(线下)使用场景重合度高、交互对用户友善的精致应用的曝光度也将提升,这种转变对App Store的个人开发者来说会更加友好。

App Library对iOS/iPadOS“主屏幕”概念的颠覆

虽然我没实际上手体验,但我发现iOS/iPadOS14的主屏幕图标左上角的X变成了-号,是不是说明通过点击这个“-”,任何应用都能从主屏幕上隐藏(而非删除)呢?如果是的话,那这个从iOS诞生之初就存在的“主屏幕”概念就将变成与Android/WP那样的“桌面”类似的概念,而App Library则会更像是macOS的Launchpad(启动台)一样的存在。

可能在不少人看来,这顶多只是“借鉴Android”什么的,但对于界限愈加模糊的新macOS和iOS /iPadOS来说,这个举动就很暧昧了。虽然从“形”上看,这个主屏幕似乎除了多了小部件以外,和iOS /iPadOS13没啥区别,但它从本质的交互上已经更趋向于macOS了,这其实是在“挑逗”用户对iOS“主屏幕”那根深蒂固的观念和使用习惯。

因此如果以后的iOS /iPadOS版本宣布可以把iCloud上的文件摆到主屏幕的话,我也不会觉得有什么奇怪了。

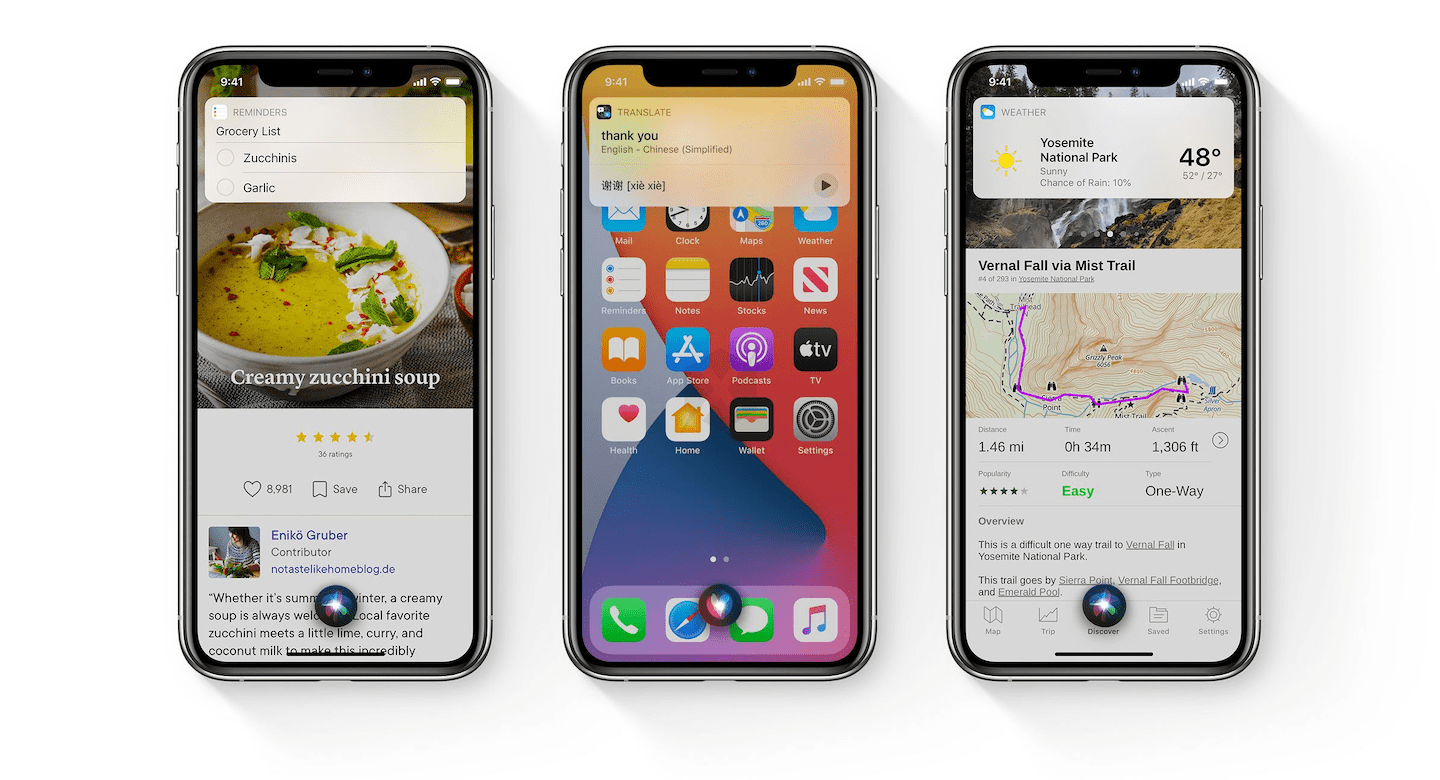

姗姗来迟的Siri“去全屏化”

似乎是顺应iOS14全面屏化的潮流,Siri也终于变“小”了。虽然据我所知,这一点原生Android好像前年就实现了。如果Siri号称是智能助理的话,那它与用户当前的使用场景融合是必须的,而不应该是需要用户在另一个界面上与之交流。原先Siri的交互会给用户造成使用体验上的割裂感,也会限制用户使用它的场景和频率。

虽然这个改进迟了点,但好歹苹果终于做了。

在我看来,这个转变对苹果生态其实是具有里程碑意义的。AirPods2的主打功能让我十分在意:可以用自带的芯片随时随地呼出Siri。加上最近苹果不断提升AirPods的存在感,让我有理由相信Siri对苹果生态的地位将会是举足轻重的。因为Siri代表着继“键鼠”和“触控”之外的第三大交互方式——“语音”,这种交互对需要解放双手的场景和特殊人群来说都十分重要,所以Siri对苹果的战略意义也是不容忽视。值得注意的是,去年WWDC19的更新所加入的“语音控制”也使得用语音进行系统级操作成为了可能。(这一点本来是想去年WWDC19后作为一篇文章,讨论一下Siri、AirPods和watchOS的联系和未来意义。结果发现自己没Watch,就鸽了。就是那篇失踪的WWDC19解析的AirPods与watchOS篇)

但是这个战略目前还存在一些缺口,我目前能想到比较明显的有两个:

Siri还不够智能(特别是对于Google Assistant来说)。不知道这一版改进大不大。但只要Siri还是个“人工智障”,那这个战略仍是个笑话;

交互上仍存在割裂。目前来说,有三个位置会用到语音输入,分别是Siri、键盘听写和上面提到的语音控制(这个目前是辅助功能)。虽然这三处同样是语音识别,但是这三者的操作是割裂的:Siri是通过长按home键/语音呼出、听写需要按下键盘上的特定按钮、而语音控制则是得先从Siri激活,再在另一套提示界面下进行操控。这次Siri的“去全屏化”便是打破这三者间割裂的重要一步。因为我没体验过iOS14,所以我不知道苹果现在到底做到了哪。但我个人觉得,在最理想的情况下,直接通过Siri进行文本语音输入和语音控制才是最符合直觉的交互。

如果这些缺口都补上了,那Siri对于苹果生态来说才能算得上真正意义上“成熟”了。

关于macOS on ARM (Apple Silicon)

这块可能是整个WWDC20最重磅的内容了。但它可能性和潜力实在太大了,在当今我甚至不敢想象它最终会走向哪里——当然,前提是不翻车的话。不过苹果的ARM之路是一步一个脚印走过来的、稳得很,(不像某软的画饼和砍砍砍),所以可以大胆奶一口。

这个我能想到最直接的结果就是苹果生态的大一统。比如开发者在开发iOS app时可以先在自己的Mac上跑一通,而不是将它运行在一个虚拟环境上。(不是很敢想,目前还是在做白日梦阶段。)

不过,我还是坚持iPadOS的交互是iPad的最优解、macOS的交互只适合键鼠使用(哪怕对于Big Sur来说)。不论是在iPad上装macOS,还是给Mac装触摸屏都是邪道。这样的“融合”对这两者的发展来说都没半点好处。当然如果苹果的“融合”是指macOS、iPadOS和iOS共用一个核,而采用各自适合的交互方式(就像目前的iOS和iPadOS那样)的话,那我真的是“哇哦”了。如果苹果真能做到这一步,那库克就和乔布斯一样功成名就了(虽然库克目前在我看来已经相当伟大了)。(顺便再给微软的UWP通用应用平台计划烧一炷香)

关于Swift

综合上面所述,现在(WWDC20后)可能是学习Swift(iOS/iPadOS/macOS开发)最好的时候。(我当真不是Swift传道士,因为我也不会Swift (真要传道我也是传JavaScript(不

如果上面画的这个饼是真的,那Swift的潜力就十分可观了,毕竟“同一份代码只需一次编译就能在三个主流平台上运行”,而且整个生态和开发体验对开发者来说也十分友好。虽然目前来说,即使借助了Catalyst,Swift还是无法做到轻松跨平台开发。当前的它距离苹果画的那个“饼”依然是任重道远,不过整个社区的状况的确是越来越好了。

这里只是不负责任地怂恿,具体还是要看个人对这门语言/苹果的生态是否感兴趣啦。

- 文/Zeee

商业转载请联系站长获得授权;

非商业转载请注明文章来源及链接。

评论0

来给这篇文章留下第一个脚印吧